Mit Wirkung zum 24. März 2025 haben Microsoft und NVIDIA mehrere neue Fortschritte in ihrer Zusammenarbeit zur Beschleunigung der KI-Entwicklung und -Leistung angekündigt. Zu diesen Änderungen gehören die Integration der neuesten NVIDIA Blackwell Plattform in die Azure AI Services Infrastruktur, die Einführung von NVIDIA NeMo Inference Microservices (NIM) in Azure AI Foundry, die Einführung von serverlosen GPUs und mehr.

Änderungen

Integration der NVIDIA Blackwell Plattform

Die NVIDIA Blackwell Plattform ist ein bedeutender Fortschritt im Bereich KI und beschleunigtes Computing und verfügt über die Blackwell GPU Architektur. Im Vergleich zu früheren Architekturen wie Hopper bietet Blackwell eine bis zu 2-fache Beschleunigung der Attention-Layer und 1,5-fache KI-Rechenleistung (FLOPS). Attention-Layer sind ein wichtiger Bestandteil moderner neuronaler Netzwerke, insbesondere in Modellen für natürliche Sprachverarbeitung (NLP). Sie helfen dem Modell, sich auf relevante Teile der Eingabedaten zu konzentrieren, indem sie den Fokus auf bestimmte Wörter oder Merkmale legen, die für die aktuelle Aufgabe wichtig sind. Diese Verbesserungen macht Blackwell ideal für die Verarbeitung von KI-Modellen mit Billionen von Parametern, die für generative KI, Datenverarbeitung und technische Simulationen entscheidend sind.

Die neueste NVIDIA Blackwell Plattform ist jetzt in die Azure AI Services Infrastruktur integriert. Diese Integration nutzt die fortschrittliche GPU-Technologie von NVIDIA, um die KI-Leistung und Effizienz auf Azure zu verbessern. KI-Anwendungen, die auf Azure laufen, profitieren automatisch von der verbesserten Geschwindigkeit und Effizienz der Blackwell-GPUs, welche nicht extra ausgewählt oder konfiguriert werden müssen.

Einführung von NVIDIA NIM Microservices

NVIDIA NIM Microservices helfen, KI-Anwendungen schnell und zuverlässig in verschiedenen Umgebungen wie Cloud und Rechenzentren bereitzustellen. Sie werden mit vorgefertigten KI-Modellen geliefert und sind für hohe Leistung und niedrige Latenzzeiten optimiert. Das macht es für Unternehmen einfacher, KI zu nutzen, ohne eine komplexe Infrastruktur zu verwalten.

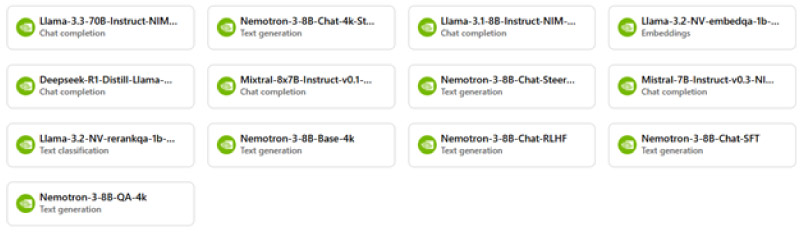

Azure AI Foundry bietet jetzt NVIDIA NIM-Microservices, mit denen Entwickler schnell leistungsoptimierte KI-Anwendungen auf den Markt bringen können. Das offene Argumentationsmodell (reasoning model) NVIDIA Llama Nemotron Reason wird in Kürze ebenfalls in Azure AI Foundry integriert werden.

Leistungsoptimierung für Meta-Lama-Modelle

Die Llama-Modelle von Meta (vorher bekannt als Facebook) sind eine Familie von großen Sprachmodellen (LLMs), die für verschiedene KI-Anwendungen entwickelt wurden. Im Vergleich zu Llama 3 bietet das neue Llama 3.1 eine erweiterte Kontexthandhabung, verbesserte Inferenzgeschwindigkeit und verbesserte multimodale Unterstützung. Sie unterstützen mehrsprachige und multimodale Fähigkeiten, so dass sie sowohl Text als auch visuelle Eingaben verarbeiten können.

Microsoft und NVIDIA haben jetzt die Leistung von Meta Llama-Modellen mit TensorRT-LLM optimiert und damit den Durchsatz und die Effizienz verbessert. Wie funktioniert diese Opimierung?

- Quantisierung: TensorRT-LLM verwendet verschiedene Quantisierungstechniken wie FP8 und INT4 AWQ, um die Modelle zu optimieren. Quantisierung reduziert die Präzision der Berechnungen, was die Geschwindigkeit erhöht, ohne die Genauigkeit wesentlich zu beeinträchtigen.

- Optimierte Attention-Kerne: Die Attention-Kerne (spezialisierte Berechnungseinheiten innerhalb eines neuronalen Netzwerks) wurden speziell angepasst, um die Berechnungen effizienter zu gestalten. Dies verbessert die Leistung der Attention-Layer (siehe oben), die für die Verarbeitung von Kontextinformationen entscheidend sind.

- KV-Caching: Durch sogenanntes „Paged KV-Caching“ können Zwischenergebnisse gespeichert und wiederverwendet werden, was die Berechnungen beschleunigt und die Latenz verringert.

- In-Flight Batching: Diese Technik ermöglicht es, mehrere Anfragen gleichzeitig zu verarbeiten, was den Durchsatz erhöht und die Effizienz verbessert.

Allgemeine Verfügbarkeit von Azure ND GB200 V6 VMs

Azure ND GB200 V6-virtuelle Maschinen wurden entwickelt, um leistungsstarkes Computing für KI- und Deep Learning-Aufgaben zu ermöglichen.

- High-Performance Computing: Diese VMs verwenden NVIDIA GB200 Blackwell GPUs, die sehr fortschrittlich und schnell sind. Dadurch eignen sie sich hervorragend für die Verarbeitung komplexer KI-Modelle und großer Datensätze.

- Effiziente Vernetzung: Sie verwenden auch NVIDIA Quantum InfiniBand Netzwerke, eine Technologie, die eine sehr schnelle und latenzarme Kommunikation zwischen Computern ermöglicht. Das bedeutet, dass Daten schnell und effizient übertragen werden können.

- Skalierbarkeit: Diese VMs können bis zu 72 GPUs in einer einzigen NVLink-Domäne verbinden. NVLink ist eine Hochgeschwindigkeitsverbindung, die es den GPUs ermöglicht, nahtlos zusammenzuarbeiten und so noch mehr Leistung und Effizienz zu erzielen.

- Verbesserte Leistung: Im Vergleich zu älteren Versionen bieten diese VMs erhebliche Verbesserungen bei Geschwindigkeit und Effizienz. Dadurch wird sichergestellt, dass anspruchsvolle KI-Workloads reibungslos und schnell ablaufen.

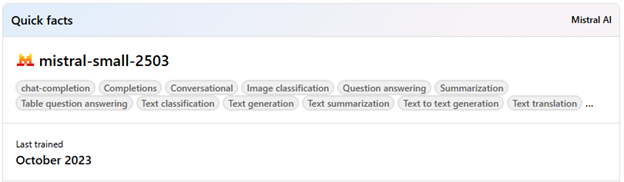

Erweiterung des Azure AI Foundry Modellkatalogs: Mistral Small 3.1

Der Azure AI Foundry-Katalog enthält jetzt Mistral Small 3.1, das multimodale Fähigkeiten und eine erweiterte Kontextlänge bietet.

Dieses Modell eignet sich hervorragend für Anwendungen wie Programmierung, Argumentation, Dialog und Dokumentenanalyse. Im Vergleich zu früheren Versionen bietet Mistral Small 3.1 eine verbesserte Textleistung, multimodales Verstehen und ein erweitertes Kontextfenster mit bis zu 128.000 Token.

Einführung von Serverlosen GPUs

Serverlose GPUs bieten eine skalierbare und flexible Lösung für die Ausführung von KI-Arbeitsleistungen auf Abruf, ohne dass eine spezielle Infrastrukturverwaltung erforderlich ist. Diese GPUs sind in einer serverlosen Umgebung verfügbar und ermöglichen automatische Skalierung, optimierten Kaltstart und sekundengenaue Abrechnung. Im Vergleich zu herkömmlichen GPU-Konfigurationen bieten serverlose GPUs die Vorteile der GPU-Beschleunigung bei gleichzeitiger Minimierung des betrieblichen Aufwands und der Kosten. Das ist wichtig, denn so können Unternehmen leistungsstarke GPU-Ressourcen für Echtzeit-Inferencing, Stapelverarbeitung und andere dynamische KI-Anwendungen nutzen, ohne die Komplexität und die Kosten der Verwaltung physischer Hardware. Echtzeit-Inferencing ist die Fähigkeit, KI-Modelle in Echtzeit zu verwenden, um sofortige Vorhersagen oder Entscheidungen zu treffen. Stapelverarbeitung ist ein Verfahren, bei dem große Mengen von Daten in Blöcken oder „Stapel“ verarbeitet werden, damit viele Daten gleichzeitig verarbeitet werden können.

Azure Container Apps unterstützen jetzt serverlose Grafikprozessoren mit NVIDIA NIM, die eine kostengünstige Lösung für die Ausführung von KI-Workloads auf Abruf bieten.

Weitere Informationen

Ankündigung: https://azure.microsoft.com/en-us/blog/microsoft-and-nvidia-accelerate-ai-development-and-performance/.

Besuchen Sie Azure AI Foundry: https://ai.azure.com/.

Kontaktieren Sie SCHNEIDER IT MANAGEMENT noch heute für eine Beratung zur Lizenzierung von Azure, um Kosten auf Azure zu sparen und von den neuesten Verbesserungen in Azure zu profitieren.