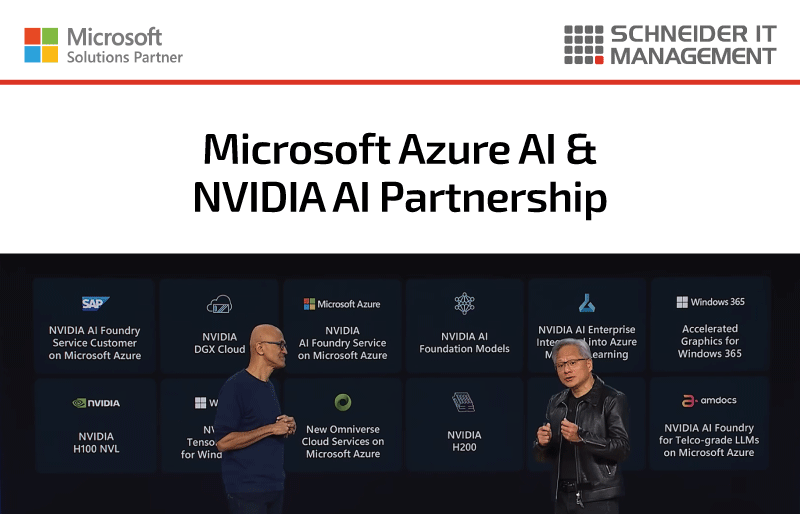

Microsoft et NVIDIA ont annoncé une collaboration visant à aider les développeurs à créer des applications compatibles avec l’IA avec Azure AI et NVIDIA AI. Ce partenariat vise à rendre plus accessibles les fonctionnalités avancées de l’IA et à réduire la complexité et les coûts du développement de l’IA.

Que sont Azure AI et NVIDIA AI ?

Azure AI est une suite complète de services d’intelligence artificielle (IA) et d’apprentissage automatique (ML) dans le cloud, proposée par Microsoft.

Elle fournit aux développeurs les outils et les ressources dont ils ont besoin pour créer, former et déployer des applications basées sur l’IA.

Ces services comprennent des modèles prédéfinis, des API et la possibilité de créer ses propres modèles.

Ils permettent aux développeurs d’intégrer plus facilement l’IA dans leurs applications.

NVIDIA AI est une plate-forme qui améliore les performances des applications d’intelligence artificielle à chaque étape de leur développement et de leur déploiement.

Elle s’appuie sur les technologies avancées de GPU et de réseau de NVIDIA pour garantir que les applications d’IA s’exécutent de manière efficace et efficiente.

Cette plate-forme prend en charge le calcul haute performance et permet aux développeurs de gérer facilement des charges de travail d’IA complexes.

Ensemble, Azure AI et NVIDIA AI offrent une puissante combinaison d’outils et d’infrastructure.

Caractéristiques principales

- Flexibilité et choix: Utilisez des modèles et des API prédéfinis ou créez et formez vos propres modèles.

Prend en charge différents frameworks et langages tels que TensorFlow, PyTorch et Python. - Productivité et efficacité: intégré avec Visual Studio Code et GitHub.

Utilisez des extensions et des actions GitHub pour simplifier et accélérer le développement de l’IA. - Performance et évolutivité: utilise les GPU NVIDIA et les réseaux InfiniBand pour une performance et une évolutivité élevées.

- Innovation et créativité: développez des applications qui comprennent les utilisateurs et les environnements, interagissent avec eux et apprennent d’eux.

Intégration d’Azure AI et de NVIDIA AI : quoi de neuf ?

Infrastructure d’IA avancée :

- Intégration avec Azure: les réseaux NVIDIA Grace Blackwell GB200 et NVIDIA Quantum-X800 InfiniBand font désormais partie d’Azure.

- Des trillions de modèles de paramètres: Azure fournit des modèles puissants pour le traitement du langage naturel, la vision par ordinateur et la reconnaissance vocale.

- Nouvelles machines virtuelles: Les machines virtuelles Azure NC H100 v5 VM, basées sur la plateforme NVIDIA H100 NVL, sont désormais disponibles.

- Flexibilité et évolutivité: la technologie NVIDIA Multi-Instance GPU (MIG) offre une flexibilité et une évolutivité améliorées.

Percées dans le domaine des soins de santé et des sciences de la vie :

- Innovation rapide: Microsoft Azure s’intègre à NVIDIA DGX Cloud et à la suite NVIDIA Clara pour accélérer la recherche clinique et les soins.

Numérisation industrielle :

- Les APIs Omniverse Cloud: Les API NVIDIA Omniverse Cloud sont désormais disponibles sur Microsoft Azure.

- Interopérabilité des données: amélioration de l’interopérabilité des données, de la collaboration et de la visualisation basée sur la physique.

- Jumeaux numériques 3D: Visualisation en temps réel des données d’usine avec des jumeaux numériques 3D dans Microsoft Power BI.

NVIDIA Triton Inference Server et Microsoft Copilot :

- Prévisions d’inférence d’IA: les GPU NVIDIA et le serveur d’inférence NVIDIA Triton prennent en charge les prévisions d’inférence d’IA dans Microsoft Copilot pour Microsoft 365.

De la formation à l’IA au déploiement de l’IA :

- Microservices NVIDIA NIM Inference: Ces microservices sont intégrés à Azure AI afin d’améliorer les déploiements d’IA.

- Partie intégrante de NVIDIA AI Enterprise: NIM est disponible sur Azure Marketplace et fournit des microservices natifs du cloud pour une inférence optimisée sur plus de deux douzaines de modèles de base populaires, y compris des modèles développés par NVIDIA.

- Conteneurs prêts à l’emploi et déployables partout: ces conteneurs, pris en charge par le logiciel d’inférence NVIDIA AI Enterprise (y compris Triton Inference Server, TensorRT et TensorRT-LLM), aident les développeurs à mettre rapidement sur le marché des applications d’IA aux performances optimisées.

FAQ

Quels outils puis-je utiliser avec Azure AI et NVIDIA AI ?

Vous pouvez utiliser Visual Studio Code, GitHub et d’autres environnements de développement populaires.

Quels sont les langages et les frameworks pris en charge ?

Les langages et frameworks supportés incluent TensorFlow, PyTorch, Scikit-learn, Python et R.

Comment le développeur profite-t-il de cette collaboration ?

Il réduit le temps de développement, diminue les coûts et améliore la collaboration et la communication entre les membres de l’équipe.

Plus d’informations

Vous trouverez l’annonce ici : https://azure.microsoft.com/en-us/blog/build-ai-enabled-applications-with-azure-ai-and-nvidia/ et https://news.microsoft.com/2024/03/18/microsoft-and-nvidia-announce-major-integrations-to-accelerate-generative-ai-for-enterprises-everywhere/.

Regardez la keynote : https://www.youtube.com/watch?v=QsWtiop4IJA.

Vous trouverez la page produit ici : https://developer.microsoft.com/en-us/ai.

Vous pouvez consulter la page de notre fabricant Microsoft à l’adresse suivante : https://www.schneider.im/fr/logiciels/microsoft.

Contactez-nous pour obtenir des services d’experts sur vos besoins spécifiques en matière de logiciels Microsoft et de services en ligne, et demandez un devis dès aujourd’hui.