Avec effet au 24 mars 2025, Microsoft et NVIDIA ont annoncé plusieurs nouvelles avancées dans leur collaboration visant à accélérer le développement et les performances de l’IA. Ces changements incluent l’intégration de la dernière plateforme NVIDIA Blackwell dans l’infrastructure Azure AI Services, l’introduction de microservices d’inférence NVIDIA NeMo (NVIDIA NeMo Inference Microservices, NIM) dans Azure AI Foundry, l’introduction de GPU sans serveur et bien plus encore.

Modifications

Intégration de la plateforme NVIDIA Blackwell

La plateforme NVIDIA Blackwell représente une avancée majeure dans le domaine de l’IA et du calcul accéléré et intègre l’architecture GPU Blackwell. Par rapport aux architectures précédentes comme Hopper, Blackwell offre une accélération des couches attention jusqu’à 2 fois plus rapide et une puissance de calcul de l’IA (FLOPS) 1,5 fois plus élevée. Les couches attention sont un élément important des réseaux neuronaux modernes, en particulier dans les modèles de traitement du langage naturel (NLP). Elles aident le modèle à se concentrer sur des parties pertinentes des données d’entrée, en mettant l’accent sur des mots ou des caractéristiques spécifiques qui sont importants pour la tâche en cours. Ces améliorations rendent Blackwell idéal pour le traitement de modèles d’IA contenant des trillions de paramètres essentiels pour l’IA générative, le traitement des données et les simulations techniques.

La dernière plateforme NVIDIA Blackwell est désormais intégrée à l’infrastructure Azure AI Services. Cette intégration exploite la technologie GPU avancée de NVIDIA pour améliorer les performances et l’efficacité de l’IA sur Azure. Les applications d’IA exécutées sur Azure bénéficient automatiquement de la vitesse et de l’efficacité améliorées des GPU Blackwell, qui n’ont pas besoin d’être sélectionnés ou configurés séparément.

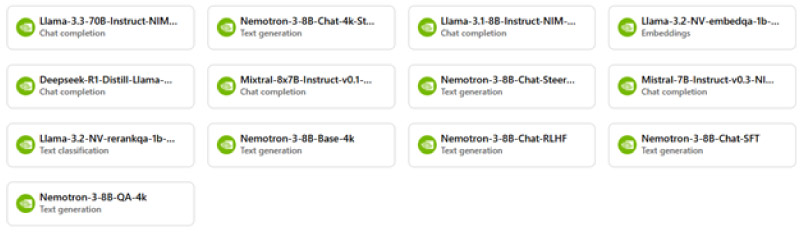

Introduction des microservices NVIDIA NIM

Les microservices NVIDIA NIM aident à déployer rapidement et de manière fiable des applications d’IA dans différents environnements tels que cloud et les centres de données. Ils sont fournis avec des modèles d’IA pré-construits et sont optimisés pour des performances élevées et une faible latence. Il est ainsi plus facile pour les entreprises d’utiliser l’IA sans avoir à gérer une infrastructure complexe.

Azure AI Foundry propose désormais des microservices NVIDIA NIM qui permettent aux développeurs de mettre rapidement sur le marché des applications d’intelligence artificielle aux performances optimisées. Le modèle de raisonnement (reasoning model) ouvert NVIDIA Llama Nemotron Reason sera également bientôt intégré à Azure AI Foundry.

Optimisation des performances pour les modèles Meta-Lama

Les modèles Llama de Meta (précédemment connu sous le nom de Facebook) sont une famille de grands modèles de langage (LLM) développés pour diverses applications d’IA. Par rapport à Llama 3, le nouveau Llama 3.1 offre une gestion avancée du contexte, une vitesse d’inférence améliorée et un support multimodal amélioré. Ils prennent en charge les capacités multilingues et multimodales, ce qui leur permet de traiter à la fois les entrées textuelles et visuelles.

Microsoft et NVIDIA ont maintenant optimisé les performances des modèles Meta Llama avec TensorRT-LLM, améliorant ainsi le débit et l’efficacité. Comment fonctionne cette optimisation ?

- Quantification : TensorRT-LLM utilise différentes techniques de quantification telles que FP8 et INT4 AWQ pour optimiser les modèles. La quantification réduit la précision des calculs, ce qui augmente la vitesse sans affecter significativement la précision.

- Noyaux Attention optimisés : Les noyaux attention (unités de calcul spécialisées au sein d’un réseau neuronal) ont été spécialement adaptés pour rendre les calculs plus efficaces. Cela améliore les performances des couches attention (voir ci-dessus), qui sont essentielles pour le traitement des informations contextuelles.

- Mise en cache du KV : La mise en cache du KV peut être utilisée pour stocker et réutiliser les résultats intermédiaires, ce qui accélère les calculs et réduit la latence.

- In-Flight Batching : Cette technique permet de traiter plusieurs requêtes simultanément, ce qui augmente le débit et améliore l’efficacité.

Disponibilité générale des VM Azure ND GB200 V6

Les machines virtuelles Azure ND GB200 V6 sont conçues pour fournir un calcul puissant pour les tâches d’intelligence artificielle et d’apprentissage profond.

- Calcul haute performance : Ces VM utilisent des GPU NVIDIA GB200 Blackwell qui sont très avancés et rapides. Cela les rend idéales pour le traitement de modèles d’IA complexes et de grands ensembles de données.

- Mise en réseau efficace : Ils utilisent également les réseaux NVIDIA Quantum InfiniBand, une technologie qui permet une communication très rapide et à faible latence entre les ordinateurs. Cela signifie que les données peuvent être transférées rapidement et efficacement.

- Évolutivité : Ces VM peuvent connecter jusqu’à 72 GPU dans un seul domaine NVLink. NVLink est une connexion à haut débit qui permet aux GPU de travailler ensemble de manière transparente pour obtenir encore plus de performances et d’efficacité.

- Performances améliorées : Par rapport aux versions antérieures, ces VM offrent des améliorations significatives en termes de vitesse et d’efficacité. Cela garantit que les charges de travail d’intelligence artificielle exigeantes s’exécutent sans problème et rapidement.

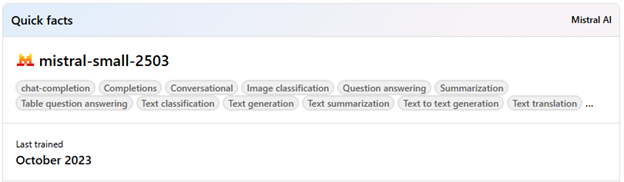

Extension du catalogue de modèles Azure AI Foundry : Mistral Small 3.1

Le catalogue Azure AI Foundry comprend désormais Mistral Small 3.1, qui offre des capacités multimodales et une longueur de contexte étendue.

Ce modèle est parfaitement adapté aux applications telles que la programmation, l’argumentation, le dialogue et l’analyse de documents. Par rapport aux versions précédentes, Mistral Small 3.1 offre des performances textuelles améliorées, une compréhension multimodale et une fenêtre contextuelle étendue pouvant contenir jusqu’à 128 000 tokens.

Introduction des GPU sans serveur

Les GPU sans serveur offrent une solution évolutive et flexible pour l’exécution de travaux d’intelligence artificielle à la demande, sans nécessiter de gestion d’infrastructure spécifique. Ces GPU sont disponibles dans un environnement sans serveur et permettent une mise à l’échelle automatique, un démarrage à froid optimisé et une facturation à la seconde. Par rapport aux configurations GPU traditionnelles, les GPU sans serveur offrent les avantages de l’accélération GPU tout en minimisant les efforts opérationnels et les coûts. C’est important car cela permet aux entreprises d’utiliser des ressources GPU puissantes pour l’inférence en temps réel, le traitement par lots et d’autres applications d’intelligence artificielle dynamiques, sans la complexité et les coûts de gestion du matériel physique. L’inférence en temps réel est la capacité d’utiliser des modèles d’IA en temps réel pour faire des prédictions ou prendre des décisions instantanées. Le traitement par lots est un processus qui consiste à traiter de grandes quantités de données par blocs ou « piles » afin de pouvoir traiter de nombreuses données simultanément.

Azure Container Apps prend désormais en charge les GPU sans serveur avec NVIDIA NIM, offrant ainsi une solution économique pour l’exécution de charges de travail d’intelligence artificielle à la demande.

Plus d’informations

Annonce de l’événement : https://azure.microsoft.com/en-us/blog/microsoft-and-nvidia-accelerate-ai-development-and-performance/.

Visitez Azure AI Foundry : https://ai.azure.com/.

Contactez SCHNEIDER IT MANAGEMENT dès aujourd’hui pour des conseils sur l’octroi de licences Azure, afin de réduire les coûts sur Azure et de bénéficier des dernières améliorations d’Azure.